学术动态

更多 +

-

计算所NLP团队2篇论文被NeurIPS 2025接收2025年9月,计算所NLP课题组有2篇论文被NeurIPS 2025录用。2025年9月,计算所NLP课题组有2篇论文被NeurIPS 2025录用。NeurIPS 2025的全称是Thirty-Ninth Conference on Neural Information Processing Systems,是人工智能领域的顶级会议之一。NeurIPS 2025将于2025年12月2日-12月7日在美国圣地亚哥会议中心召开,并在11月30日-12月5日在墨西哥城设立第二会场。 1. Efficient Speech Language Modeling via Energy Distance in Continuous Latent Space作者:Zhengrui Ma, Yang Feng*, Chenze Shao, Fandong Meng, Jie Zhou, Min Zhang简介:我们提出了一种新的语音语言建模方法 SLED。它先把语音波形编码成一串连续的潜在表示,再用能量距离(energy distance)作为目标进行自回归建模。能量距离能够通过对比模拟样本与目标样本,给出分布差异的解析度量,从而高效地学习底层的连续自回归分布。得益于不再依赖残差向量量化(RVQ),SLED 避免了离散化误差,也省去了许多现有语音语言模型常见的繁复分层结构。整体流程因此更简洁,同时又能保留语音信息的丰富性,并维持推理效率。实验表明,SLED 在零样本和流式语音合成上都取得了出色表现,显示出向通用型语音语言模型扩展的潜力。Paper: https://arxiv.org/abs/2505.13181Code: https://github.com/ictnlp/SLED-TTS2. FastLongSpeech: Enhancing Large Speech-Language Models for Efficient Long-Speech Processing 作者:Shoutao Guo, Shaolei Zhang, Qingkai Fang, Zhengrui Ma, Min Zhang, Yang Feng*简介:大型语言模型(LLMs)的快速发展推动了语音大模型(LSLMs)的显著进步,增强了其在语音理解和语音生成方面的能力。现有的 LSLMs 往往侧重于提升语音生成能力或解决多样化的短语音任务,但对长语音的高效处理仍然是一个关键却尚未被充分探索的挑战。这一缺口主要源于长语音训练数据集的稀缺,以及处理长序列所需的高计算成本。为克服这些限制,我们提出了 FastLongSpeech,一种旨在扩展 LSLM 能力、实现高效长语音处理的新型框架,而无需依赖专门的长语音训练数据。FastLongSpeech 融合了一种迭代压缩策略,可将过长的语音序列压缩至可管理的长度。为了使 LSLMs 适应长语音输入,该框架引入了一种动态压缩训练方法,使模型在不同压缩比下接触短语音序列,从而将 LSLMs 的能力迁移到长语音任务中。此外,我们构建了一个长语音理解基准测试 LongSpeech-Eval,用于评估 LSLMs 的长语音处理能力。实验结果表明,我们的方法在长语音与短语音任务中均表现出强劲性能,并显著提升了推理效率。Paper: https://arxiv.org/abs/2507.14815Code: https://github.com/ictnlp/FastLongSpeech.git2025-09-29

计算所NLP团队2篇论文被NeurIPS 2025接收2025年9月,计算所NLP课题组有2篇论文被NeurIPS 2025录用。2025年9月,计算所NLP课题组有2篇论文被NeurIPS 2025录用。NeurIPS 2025的全称是Thirty-Ninth Conference on Neural Information Processing Systems,是人工智能领域的顶级会议之一。NeurIPS 2025将于2025年12月2日-12月7日在美国圣地亚哥会议中心召开,并在11月30日-12月5日在墨西哥城设立第二会场。 1. Efficient Speech Language Modeling via Energy Distance in Continuous Latent Space作者:Zhengrui Ma, Yang Feng*, Chenze Shao, Fandong Meng, Jie Zhou, Min Zhang简介:我们提出了一种新的语音语言建模方法 SLED。它先把语音波形编码成一串连续的潜在表示,再用能量距离(energy distance)作为目标进行自回归建模。能量距离能够通过对比模拟样本与目标样本,给出分布差异的解析度量,从而高效地学习底层的连续自回归分布。得益于不再依赖残差向量量化(RVQ),SLED 避免了离散化误差,也省去了许多现有语音语言模型常见的繁复分层结构。整体流程因此更简洁,同时又能保留语音信息的丰富性,并维持推理效率。实验表明,SLED 在零样本和流式语音合成上都取得了出色表现,显示出向通用型语音语言模型扩展的潜力。Paper: https://arxiv.org/abs/2505.13181Code: https://github.com/ictnlp/SLED-TTS2. FastLongSpeech: Enhancing Large Speech-Language Models for Efficient Long-Speech Processing 作者:Shoutao Guo, Shaolei Zhang, Qingkai Fang, Zhengrui Ma, Min Zhang, Yang Feng*简介:大型语言模型(LLMs)的快速发展推动了语音大模型(LSLMs)的显著进步,增强了其在语音理解和语音生成方面的能力。现有的 LSLMs 往往侧重于提升语音生成能力或解决多样化的短语音任务,但对长语音的高效处理仍然是一个关键却尚未被充分探索的挑战。这一缺口主要源于长语音训练数据集的稀缺,以及处理长序列所需的高计算成本。为克服这些限制,我们提出了 FastLongSpeech,一种旨在扩展 LSLM 能力、实现高效长语音处理的新型框架,而无需依赖专门的长语音训练数据。FastLongSpeech 融合了一种迭代压缩策略,可将过长的语音序列压缩至可管理的长度。为了使 LSLMs 适应长语音输入,该框架引入了一种动态压缩训练方法,使模型在不同压缩比下接触短语音序列,从而将 LSLMs 的能力迁移到长语音任务中。此外,我们构建了一个长语音理解基准测试 LongSpeech-Eval,用于评估 LSLMs 的长语音处理能力。实验结果表明,我们的方法在长语音与短语音任务中均表现出强劲性能,并显著提升了推理效率。Paper: https://arxiv.org/abs/2507.14815Code: https://github.com/ictnlp/FastLongSpeech.git2025-09-29 -

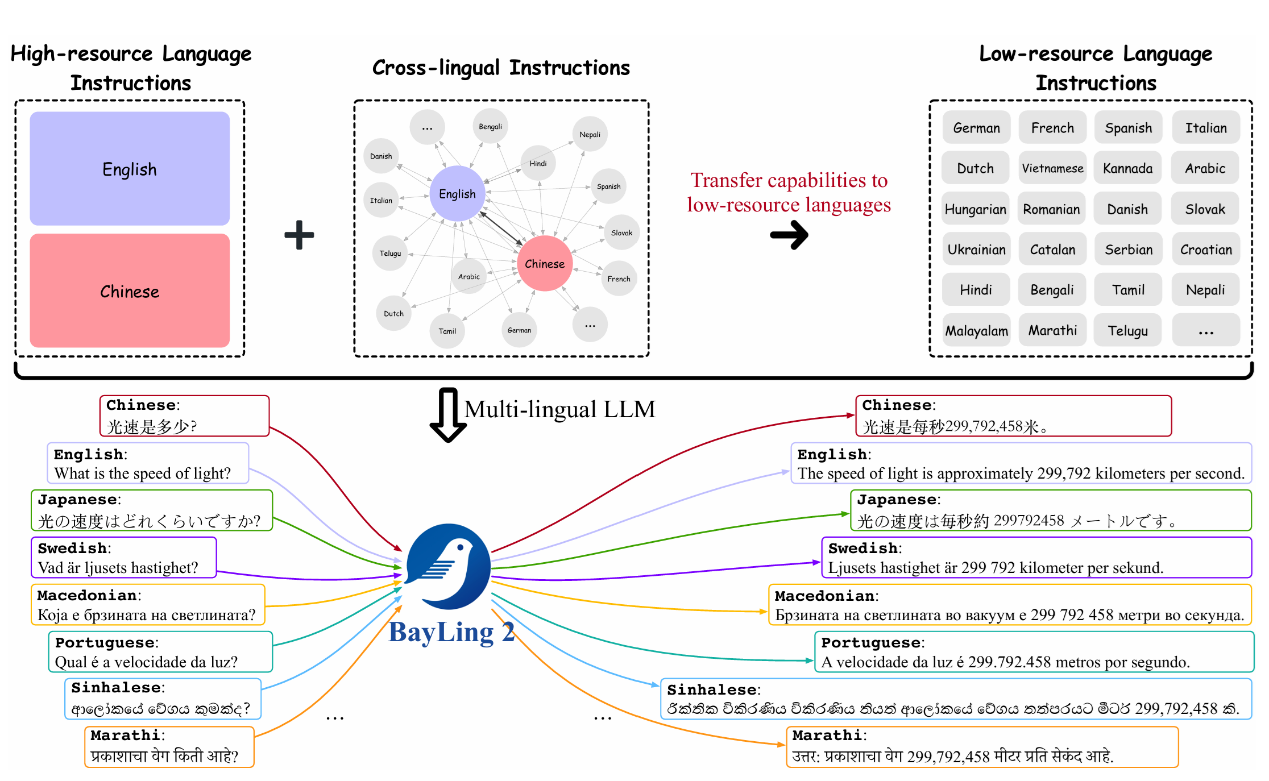

NLP组2篇论文被EMNLP 2025主会录用2025年8月,自然语言处理团队2篇论文被EMNLP 2025主会录用。2025年8月,自然语言处理团队2篇论文被EMNLP 2025主会录用。EMNLP的全称是Conference on Empirical Methods in Natural Language Processing,每年举办一次,是自然语言处理领域公认的三大顶级国际会议之一。此次会议将于2025年11月4日到9日在中国苏州召开。被录用论文的简要介绍如下:1. AlignX: Advancing Multilingual Large Language Models with Multilingual Representation Alignment(Main Conference)Mengyu Bu, Shaolei Zhang, Zhongjun He, Hua Wu, Yang Feng简介:多语言大型语言模型(LLM)具备出色的多语言理解与生成能力。然而,其性能及跨语言对齐效果在非主流语言(如英语)中往往表现欠佳。常见的解决方案是在大规模且更均衡的多语言数据集对LLM进行微调,但此类方法常导致对齐不精准及知识迁移效果不佳,难以实现跨语言的显著提升。本文提出AlignX框架以弥合多语言性能差距,该框架是一个两阶段的表示层级框架,旨在提升预训练LLM的多语言性能。在第一阶段,我们通过多语言语义对齐和语言特征整合来对齐多语言表示。在第二阶段,我们通过多语言指令微调来激发LLM的多语言能力。在多个预训练LLM上的实验结果表明,我们的方法提升了LLM的多语言通用生成能力和跨语言生成能力。进一步分析表明,AlignX使多语言表示更加接近,并改善了跨语言知识对齐水平。2. IG-Pruning: Input-Guided Block Pruning for Large Language Models (Main Conference)Kangyu Qiao, Shaolei Zhang, Yang Feng简介:随着大型语言模型(LLMs)日益增长的计算需求,高效推理对于实际部署已变得至关重要。通过移除Transformer层来降低大型语言模型计算成本的深度剪枝技术,已成为一种极具前景的方法。然而,现有方法通常依赖固定的掩码,这可能导致模型在不同任务和输入上的性能不佳。在本文中,我们提出了一种名为 IG-Pruning 的新颖方法,它是一种输入感知的模块级剪枝方法,能够在推理时动态选择层的掩码。我们的方法包含两个阶段:1)通过语义聚类和 L0 优化发现多样化的候选掩码。2)无需大量训练即可实现高效的动态剪枝。实验结果表明,我们的方法性能稳定优于当前最先进的静态深度剪枝方法,因此特别适用于资源受限的部署场景。2025-08-29

NLP组2篇论文被EMNLP 2025主会录用2025年8月,自然语言处理团队2篇论文被EMNLP 2025主会录用。2025年8月,自然语言处理团队2篇论文被EMNLP 2025主会录用。EMNLP的全称是Conference on Empirical Methods in Natural Language Processing,每年举办一次,是自然语言处理领域公认的三大顶级国际会议之一。此次会议将于2025年11月4日到9日在中国苏州召开。被录用论文的简要介绍如下:1. AlignX: Advancing Multilingual Large Language Models with Multilingual Representation Alignment(Main Conference)Mengyu Bu, Shaolei Zhang, Zhongjun He, Hua Wu, Yang Feng简介:多语言大型语言模型(LLM)具备出色的多语言理解与生成能力。然而,其性能及跨语言对齐效果在非主流语言(如英语)中往往表现欠佳。常见的解决方案是在大规模且更均衡的多语言数据集对LLM进行微调,但此类方法常导致对齐不精准及知识迁移效果不佳,难以实现跨语言的显著提升。本文提出AlignX框架以弥合多语言性能差距,该框架是一个两阶段的表示层级框架,旨在提升预训练LLM的多语言性能。在第一阶段,我们通过多语言语义对齐和语言特征整合来对齐多语言表示。在第二阶段,我们通过多语言指令微调来激发LLM的多语言能力。在多个预训练LLM上的实验结果表明,我们的方法提升了LLM的多语言通用生成能力和跨语言生成能力。进一步分析表明,AlignX使多语言表示更加接近,并改善了跨语言知识对齐水平。2. IG-Pruning: Input-Guided Block Pruning for Large Language Models (Main Conference)Kangyu Qiao, Shaolei Zhang, Yang Feng简介:随着大型语言模型(LLMs)日益增长的计算需求,高效推理对于实际部署已变得至关重要。通过移除Transformer层来降低大型语言模型计算成本的深度剪枝技术,已成为一种极具前景的方法。然而,现有方法通常依赖固定的掩码,这可能导致模型在不同任务和输入上的性能不佳。在本文中,我们提出了一种名为 IG-Pruning 的新颖方法,它是一种输入感知的模块级剪枝方法,能够在推理时动态选择层的掩码。我们的方法包含两个阶段:1)通过语义聚类和 L0 优化发现多样化的候选掩码。2)无需大量训练即可实现高效的动态剪枝。实验结果表明,我们的方法性能稳定优于当前最先进的静态深度剪枝方法,因此特别适用于资源受限的部署场景。2025-08-29 -

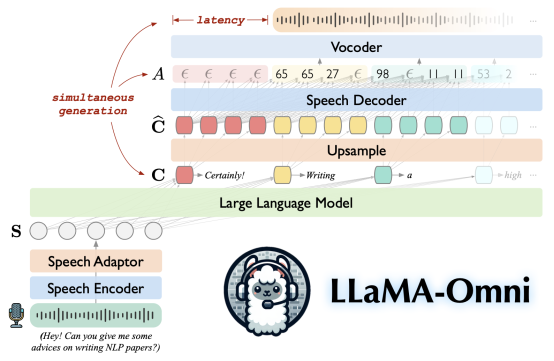

NLP组1篇论文被ACL 2025接收2025年5月,自然语言处理组1篇论文被ACL 2025主会接收。2025年5月,自然语言处理组1篇论文被ACL 2025主会接收。 ACL的全称是The Association for Computational Linguistics,是国际计算语言学界影响力最大的学术组织。ACL年度会议也是计算语言学领域的最重要的国际会议,是CCF推荐的计算语言学方面唯一的A类会议。被录用论文的简要介绍如下:1. LLaMA-Omni 2: LLM-based Real-time Spoken Chatbot with Autoregressive Streaming Speech Synthesis (Qingkai Fang, Yan Zhou, Shoutao Guo, Shaolei Zhang, Yang Feng)Accepted by ACL 2025 Main Conference简介:实时、智能、自然的语音交互是下一代人机交互不可或缺的组成部分。近期的技术进展已经展现了基于大语言模型(LLMs)构建智能语音聊天机器人的巨大潜力。在此,我们推出LLaMA-Omni 2,这是一系列参数规模从0.5B到14B的语音语言模型(SpeechLMs),能够实现高质量的实时语音交互。LLaMA-Omni 2基于Qwen2.5系列模型构建,集成了语音编码器和自回归流式语音解码器。尽管LLaMA-Omni 2仅使用了20万条多轮语音对话样本进行训练,但在多个口语问答和语音指令遵循的基准测试中表现出色,其性能超越了以往顶尖的语音语言模型,例如在数百万小时语音数据上训练的GLM-4-Voice。<!--!doctype-->2025-05-23

NLP组1篇论文被ACL 2025接收2025年5月,自然语言处理组1篇论文被ACL 2025主会接收。2025年5月,自然语言处理组1篇论文被ACL 2025主会接收。 ACL的全称是The Association for Computational Linguistics,是国际计算语言学界影响力最大的学术组织。ACL年度会议也是计算语言学领域的最重要的国际会议,是CCF推荐的计算语言学方面唯一的A类会议。被录用论文的简要介绍如下:1. LLaMA-Omni 2: LLM-based Real-time Spoken Chatbot with Autoregressive Streaming Speech Synthesis (Qingkai Fang, Yan Zhou, Shoutao Guo, Shaolei Zhang, Yang Feng)Accepted by ACL 2025 Main Conference简介:实时、智能、自然的语音交互是下一代人机交互不可或缺的组成部分。近期的技术进展已经展现了基于大语言模型(LLMs)构建智能语音聊天机器人的巨大潜力。在此,我们推出LLaMA-Omni 2,这是一系列参数规模从0.5B到14B的语音语言模型(SpeechLMs),能够实现高质量的实时语音交互。LLaMA-Omni 2基于Qwen2.5系列模型构建,集成了语音编码器和自回归流式语音解码器。尽管LLaMA-Omni 2仅使用了20万条多轮语音对话样本进行训练,但在多个口语问答和语音指令遵循的基准测试中表现出色,其性能超越了以往顶尖的语音语言模型,例如在数百万小时语音数据上训练的GLM-4-Voice。<!--!doctype-->2025-05-23 -

NLP课题组1篇论文被ICML 2025接收2025年5月,自然语言处理组1篇论文被ICML 2025接收2025年5月,自然语言处理组1篇论文被ICML 2025接收。ICML 2025的全称是The Forty-Second International Conference on Machine Learning。ICML,ICLR和NeurIPS是三大机器学习和人工智能会议,在相关领域有较大的影响力和关注度。ICML 2025将于2025年7月13日-7月19日在加拿大温哥华举行。被录用论文的简要介绍如下:1.Overcoming Non-monotonicity in Transducer-based Streaming Generation (Zhengrui Ma, Yang Feng,Min Zhang)简介:流式生成模型在多个领域中有着广泛的应用,其中 Transducer 架构在工业界中尤为流行。然而,其输入同步的解码机制在处理具有非单调对齐特性的任务时面临着挑战。为了解决这一问题,本研究尝试通过可学习的单调注意力机制结合 Transducer 的解码流与输入流信息。我们的方法利用前向-后向算法推断预测器状态与输入时间戳之间对齐的后验概率,并在训练过程中据此估计单调注意力的上下文表示,以避免对指数级对齐空间的穷举。大量实验结果表明,我们提出的 MonoAttn-Transducer 在处理流式生成中的非单调对齐方面表现显著提升,为应对复杂的流式生成任务提供了一种稳健的解决方案。<!--!doctype-->2025-05-16

NLP课题组1篇论文被ICML 2025接收2025年5月,自然语言处理组1篇论文被ICML 2025接收2025年5月,自然语言处理组1篇论文被ICML 2025接收。ICML 2025的全称是The Forty-Second International Conference on Machine Learning。ICML,ICLR和NeurIPS是三大机器学习和人工智能会议,在相关领域有较大的影响力和关注度。ICML 2025将于2025年7月13日-7月19日在加拿大温哥华举行。被录用论文的简要介绍如下:1.Overcoming Non-monotonicity in Transducer-based Streaming Generation (Zhengrui Ma, Yang Feng,Min Zhang)简介:流式生成模型在多个领域中有着广泛的应用,其中 Transducer 架构在工业界中尤为流行。然而,其输入同步的解码机制在处理具有非单调对齐特性的任务时面临着挑战。为了解决这一问题,本研究尝试通过可学习的单调注意力机制结合 Transducer 的解码流与输入流信息。我们的方法利用前向-后向算法推断预测器状态与输入时间戳之间对齐的后验概率,并在训练过程中据此估计单调注意力的上下文表示,以避免对指数级对齐空间的穷举。大量实验结果表明,我们提出的 MonoAttn-Transducer 在处理流式生成中的非单调对齐方面表现显著提升,为应对复杂的流式生成任务提供了一种稳健的解决方案。<!--!doctype-->2025-05-16