被录用论文的简要介绍如下:

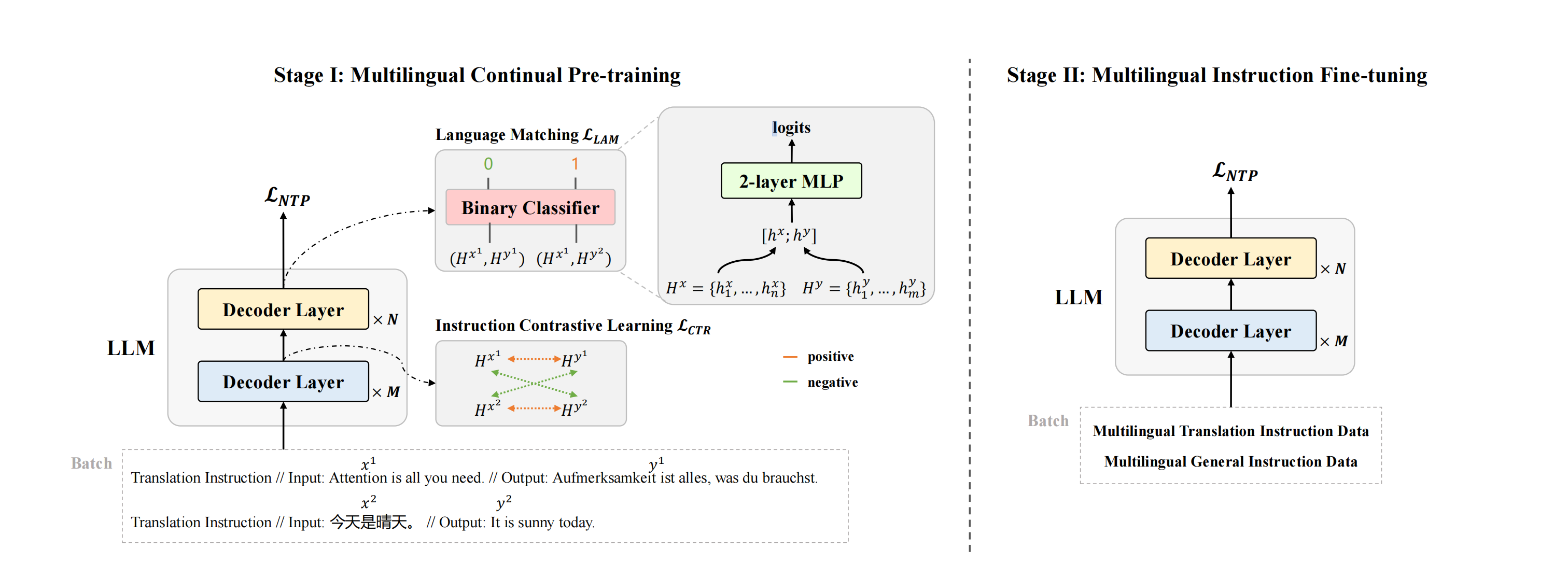

1. AlignX: Advancing Multilingual Large Language Models with Multilingual Representation Alignment(Main Conference)

Mengyu Bu, Shaolei Zhang, Zhongjun He, Hua Wu, Yang Feng

简介:多语言大型语言模型(LLM)具备出色的多语言理解与生成能力。然而,其性能及跨语言对齐效果在非主流语言(如英语)中往往表现欠佳。常见的解决方案是在大规模且更均衡的多语言数据集对LLM进行微调,但此类方法常导致对齐不精准及知识迁移效果不佳,难以实现跨语言的显著提升。本文提出AlignX框架以弥合多语言性能差距,该框架是一个两阶段的表示层级框架,旨在提升预训练LLM的多语言性能。在第一阶段,我们通过多语言语义对齐和语言特征整合来对齐多语言表示。在第二阶段,我们通过多语言指令微调来激发LLM的多语言能力。在多个预训练LLM上的实验结果表明,我们的方法提升了LLM的多语言通用生成能力和跨语言生成能力。进一步分析表明,AlignX使多语言表示更加接近,并改善了跨语言知识对齐水平。

2. IG-Pruning: Input-Guided Block Pruning for Large Language Models (Main Conference)

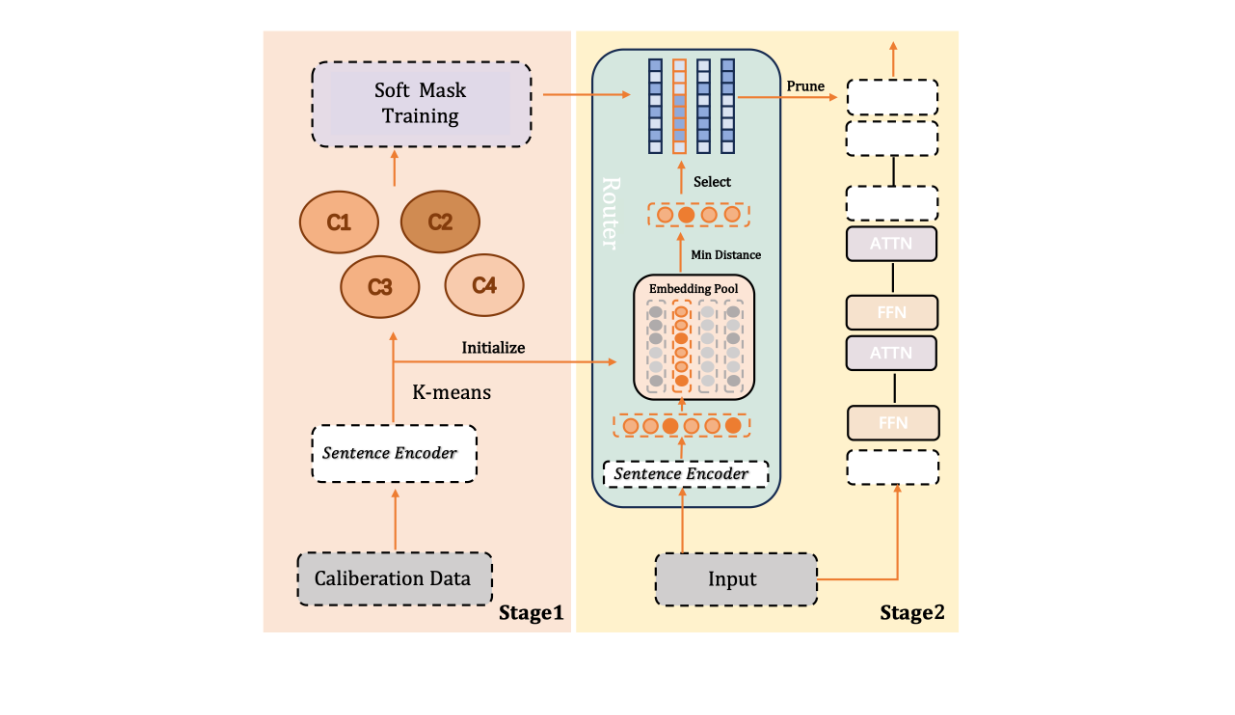

Kangyu Qiao, Shaolei Zhang, Yang Feng

简介:随着大型语言模型(LLMs)日益增长的计算需求,高效推理对于实际部署已变得至关重要。通过移除Transformer层来降低大型语言模型计算成本的深度剪枝技术,已成为一种极具前景的方法。然而,现有方法通常依赖固定的掩码,这可能导致模型在不同任务和输入上的性能不佳。在本文中,我们提出了一种名为 IG-Pruning 的新颖方法,它是一种输入感知的模块级剪枝方法,能够在推理时动态选择层的掩码。我们的方法包含两个阶段:1)通过语义聚类和 L0 优化发现多样化的候选掩码。2)无需大量训练即可实现高效的动态剪枝。实验结果表明,我们的方法性能稳定优于当前最先进的静态深度剪枝方法,因此特别适用于资源受限的部署场景。