2025年9月,计算所NLP课题组有2篇论文被NeurIPS 2025录用。NeurIPS 2025的全称是Thirty-Ninth Conference on Neural Information Processing Systems,是人工智能领域的顶级会议之一。NeurIPS 2025将于2025年12月2日-12月7日在美国圣地亚哥会议中心召开,并在11月30日-12月5日在墨西哥城设立第二会场。

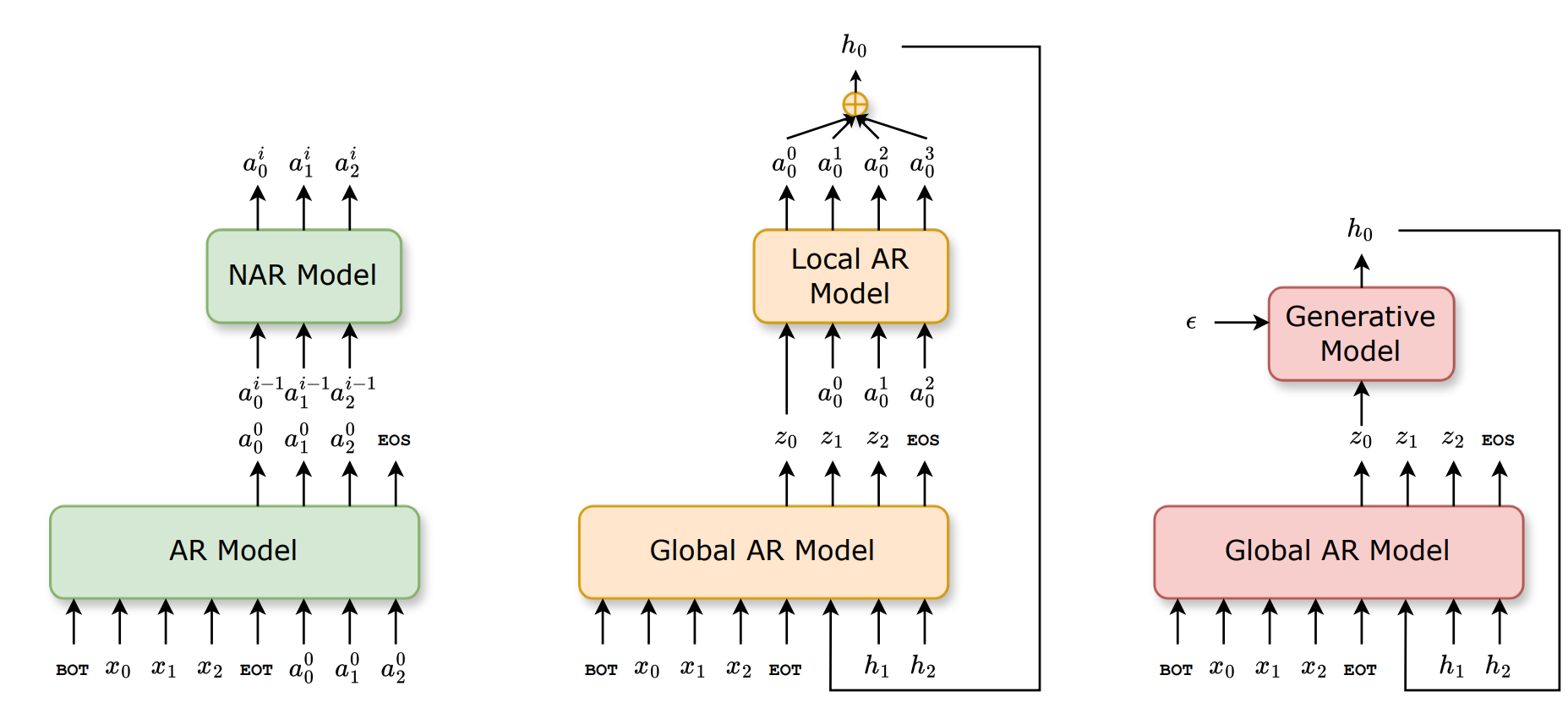

1. Efficient Speech Language Modeling via Energy Distance in Continuous Latent Space

作者:Zhengrui Ma, Yang Feng*, Chenze Shao, Fandong Meng, Jie Zhou, Min Zhang

简介:我们提出了一种新的语音语言建模方法 SLED。它先把语音波形编码成一串连续的潜在表示,再用能量距离(energy distance)作为目标进行自回归建模。能量距离能够通过对比模拟样本与目标样本,给出分布差异的解析度量,从而高效地学习底层的连续自回归分布。得益于不再依赖残差向量量化(RVQ),SLED 避免了离散化误差,也省去了许多现有语音语言模型常见的繁复分层结构。整体流程因此更简洁,同时又能保留语音信息的丰富性,并维持推理效率。实验表明,SLED 在零样本和流式语音合成上都取得了出色表现,显示出向通用型语音语言模型扩展的潜力。

Paper: https://arxiv.org/abs/2505.13181

Code: https://github.com/ictnlp/SLED-TTS

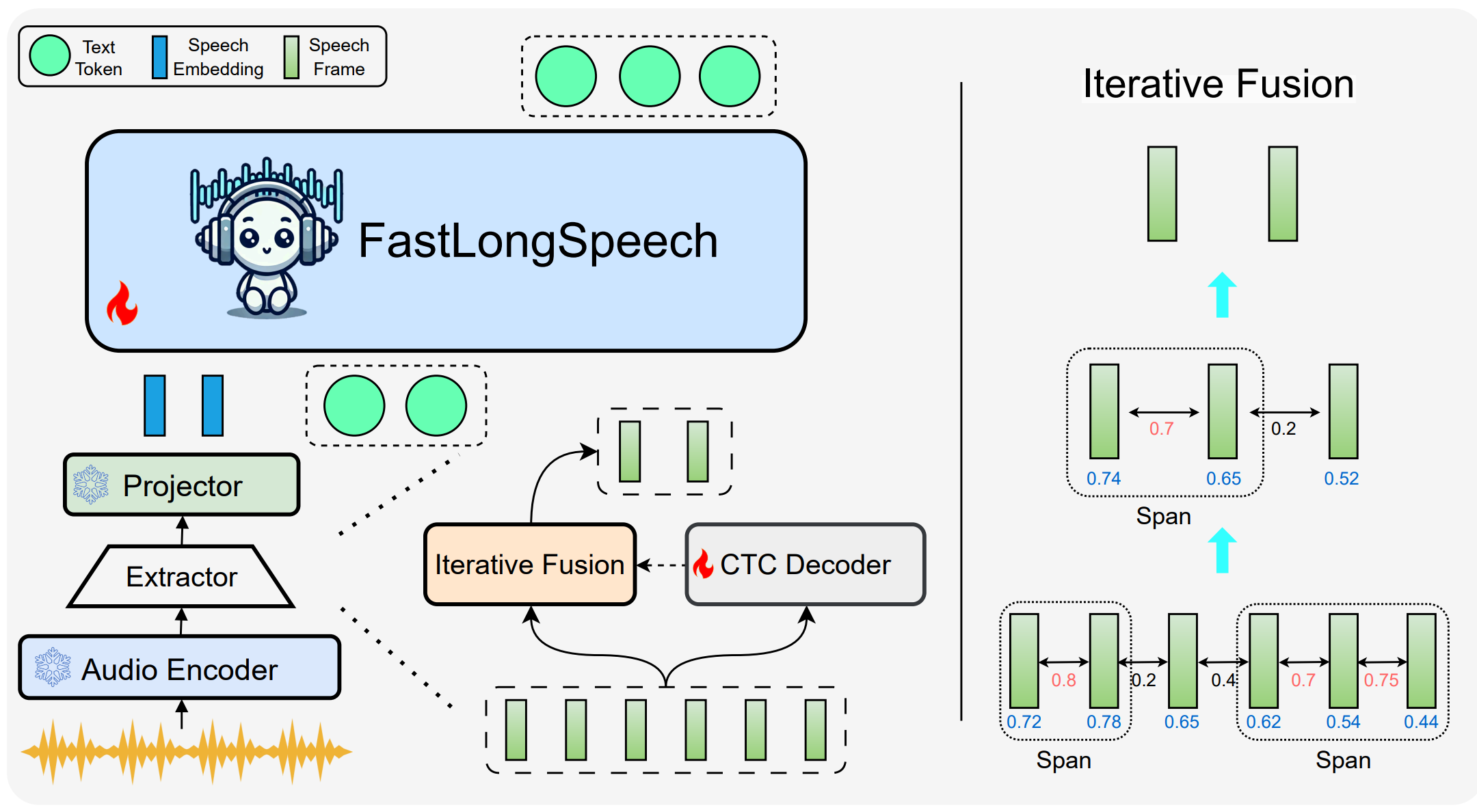

2. FastLongSpeech: Enhancing Large Speech-Language Models for Efficient Long-Speech Processing

作者:Shoutao Guo, Shaolei Zhang, Qingkai Fang, Zhengrui Ma, Min Zhang, Yang Feng*

简介:大型语言模型(LLMs)的快速发展推动了语音大模型(LSLMs)的显著进步,增强了其在语音理解和语音生成方面的能力。现有的 LSLMs 往往侧重于提升语音生成能力或解决多样化的短语音任务,但对长语音的高效处理仍然是一个关键却尚未被充分探索的挑战。这一缺口主要源于长语音训练数据集的稀缺,以及处理长序列所需的高计算成本。为克服这些限制,我们提出了 FastLongSpeech,一种旨在扩展 LSLM 能力、实现高效长语音处理的新型框架,而无需依赖专门的长语音训练数据。FastLongSpeech 融合了一种迭代压缩策略,可将过长的语音序列压缩至可管理的长度。为了使 LSLMs 适应长语音输入,该框架引入了一种动态压缩训练方法,使模型在不同压缩比下接触短语音序列,从而将 LSLMs 的能力迁移到长语音任务中。此外,我们构建了一个长语音理解基准测试 LongSpeech-Eval,用于评估 LSLMs 的长语音处理能力。实验结果表明,我们的方法在长语音与短语音任务中均表现出强劲性能,并显著提升了推理效率。

Paper: https://arxiv.org/abs/2507.14815

Code: https://github.com/ictnlp/FastLongSpeech.git